Added Hindi docs for smolagents (#279)

This commit is contained in:

parent

a4612c98dc

commit

bd08d6485d

|

|

@ -0,0 +1,14 @@

|

|||

# docstyle-ignore

|

||||

INSTALL_CONTENT = """

|

||||

# Installation

|

||||

! pip install smolagents

|

||||

# To install from source instead of the last release, comment the command above and uncomment the following one.

|

||||

# ! pip install git+https://github.com/huggingface/smolagents.git

|

||||

"""

|

||||

|

||||

notebook_first_cells = [{"type": "code", "content": INSTALL_CONTENT}]

|

||||

black_avoid_patterns = {

|

||||

"{processor_class}": "FakeProcessorClass",

|

||||

"{model_class}": "FakeModelClass",

|

||||

"{object_class}": "FakeObjectClass",

|

||||

}

|

||||

|

|

@ -0,0 +1,36 @@

|

|||

- title: Get started

|

||||

sections:

|

||||

- local: index

|

||||

title: 🤗 Agents

|

||||

- local: guided_tour

|

||||

title: गाइडेड टूर

|

||||

- title: Tutorials

|

||||

sections:

|

||||

- local: tutorials/building_good_agents

|

||||

title: ✨ अच्छे Agents का निर्माण

|

||||

- local: tutorials/inspect_runs

|

||||

title: 📊 OpenTelemetry के साथ runs का निरीक्षण

|

||||

- local: tutorials/tools

|

||||

title: 🛠️ Tools - in-depth guide

|

||||

- local: tutorials/secure_code_execution

|

||||

title: 🛡️ E2B के साथ अपने कोड एक्जीक्यूशन को सुरक्षित करें

|

||||

- title: Conceptual guides

|

||||

sections:

|

||||

- local: conceptual_guides/intro_agents

|

||||

title: 🤖 Agentic सिस्टम का परिचय

|

||||

- local: conceptual_guides/react

|

||||

title: 🤔 मल्टी-स्टेप एजेंट कैसे काम करते हैं?

|

||||

- title: Examples

|

||||

sections:

|

||||

- local: examples/text_to_sql

|

||||

title: सेल्फ करेक्टिंग Text-to-SQL

|

||||

- local: examples/rag

|

||||

title: एजेंटिक RAG के साथ अपनी ज्ञान आधारित को मास्टर करें

|

||||

- local: examples/multiagents

|

||||

title: एक बहु-एजेंट प्रणाली का आयोजन करें

|

||||

- title: Reference

|

||||

sections:

|

||||

- local: reference/agents

|

||||

title: एजेंट से संबंधित ऑब्जेक्ट्स

|

||||

- local: reference/tools

|

||||

title: टूल्स से संबंधित ऑब्जेक्ट्स

|

||||

|

|

@ -0,0 +1,115 @@

|

|||

<!--Copyright 2024 The HuggingFace Team. All rights reserved.

|

||||

|

||||

Licensed under the Apache License, Version 2.0 (the "License"); you may not use this file except in compliance with

|

||||

the License. You may obtain a copy of the License at

|

||||

|

||||

http://www.apache.org/licenses/LICENSE-2.0

|

||||

|

||||

Unless required by applicable law or agreed to in writing, software distributed under the License is distributed on

|

||||

an "AS IS" BASIS, WITHOUT WARRANTIES OR CONDITIONS OF ANY KIND, either express or implied. See the License for the

|

||||

specific language governing permissions and limitations under the License.

|

||||

|

||||

⚠️ Note that this file is in Markdown but contain specific syntax for our doc-builder (similar to MDX) that may not be

|

||||

rendered properly in your Markdown viewer.

|

||||

|

||||

-->

|

||||

# Agents का परिचय

|

||||

|

||||

## 🤔 Agents क्या हैं?

|

||||

|

||||

AI का उपयोग करने वाली किसी भी कुशल प्रणाली को LLM को वास्तविक दुनिया तक किसी प्रकार की पहुंच प्रदान करने की आवश्यकता होगी: उदाहरण के लिए बाहरी जानकारी प्राप्त करने के लिए एक खोज टूल को कॉल करने की संभावना, या किसी कार्य को हल करने के लिए कुछ प्रोग्राम पर कार्य करने की। दूसरे शब्दों में, LLM में ***agency*** होनी चाहिए। एजेंटिक प्रोग्राम LLM के लिए बाहरी दुनिया का प्रवेश द्वार हैं।

|

||||

|

||||

> [!TIP]

|

||||

> AI Agents वे **प्रोग्राम हैं जहां LLM आउटपुट वर्कफ़्लो को नियंत्रित करते हैं**।

|

||||

|

||||

LLM का उपयोग करने वाली कोई भी प्रणाली LLM आउटपुट को कोड में एकीकृत करेगी। कोड वर्कफ़्लो पर LLM के इनपुट का प्रभाव सिस्टम में LLM की एजेंसी का स्तर है।

|

||||

|

||||

ध्यान दें कि इस परिभाषा के साथ, "agent" एक अलग, 0 या 1 परिभाषा नहीं है: इसके बजाय, "agency" एक निरंतर स्पेक्ट्रम पर विकसित होती है, जैसे-जैसे आप अपने वर्कफ़्लो पर LLM को अधिक या कम शक्ति देते हैं।

|

||||

|

||||

नीचे दी गई तालिका में देखें कि कैसे एजेंसी विभिन्न प्रणालियों में भिन्न हो सकती है:

|

||||

|

||||

| एजेंसी स्तर | विवरण | इसे क्या कहा जाता है | उदाहरण पैटर्न |

|

||||

|------------|---------|-------------------|----------------|

|

||||

| ☆☆☆ | LLM आउटपुट का प्रोग्राम प्रवाह पर कोई प्रभाव नहीं | सरल प्रोसेसर | `process_llm_output(llm_response)` |

|

||||

| ★☆☆ | LLM आउटपुट if/else स्विच निर्धारित करता है | राउटर | `if llm_decision(): path_a() else: path_b()` |

|

||||

| ★★☆ | LLM आउटपुट फंक्शन एक्जीक्यूशन निर्धारित करता है | टूल कॉलर | `run_function(llm_chosen_tool, llm_chosen_args)` |

|

||||

| ★★★ | LLM आउटपुट पुनरावृत्ति और प्रोग्राम की निरंतरता को नियंत्रित करता है | मल्टी-स्टेप एजेंट | `while llm_should_continue(): execute_next_step()` |

|

||||

| ★★★ | एक एजेंटिक वर्कफ़्लो दूसरे एजेंटिक वर्कफ़्लो को शुरू कर सकता है | मल्टी-एजेंट | `if llm_trigger(): execute_agent()` |

|

||||

|

||||

मल्टी-स्टेप agent की यह कोड संरचना है:

|

||||

|

||||

```python

|

||||

memory = [user_defined_task]

|

||||

while llm_should_continue(memory): # यह लूप मल्टी-स्टेप भाग है

|

||||

action = llm_get_next_action(memory) # यह टूल-कॉलिंग भाग है

|

||||

observations = execute_action(action)

|

||||

memory += [action, observations]

|

||||

```

|

||||

|

||||

यह एजेंटिक सिस्टम एक लूप में चलता है, प्रत्येक चरण में एक नई क्रिया को शुरू करता है (क्रिया में कुछ पूर्व-निर्धारित *tools* को कॉल करना शामिल हो सकता है जो केवल फंक्शंस हैं), जब तक कि उसके अवलोकन से यह स्पष्ट न हो जाए कि दिए गए कार्य को हल करने के लिए एक संतोषजनक स्थिति प्राप्त कर ली गई है।

|

||||

|

||||

## ✅ Agents का उपयोग कब करें / ⛔ कब उनसे बचें

|

||||

|

||||

Agents तब उपयोगी होते हैं जब आपको किसी ऐप के वर्कफ़्लो को निर्धारित करने के लिए LLM की आवश्यकता होती है। लेकिन वे अक्सर जरूरत से ज्यादा होते हैं। सवाल यह है कि, क्या मुझे वास्तव में दिए गए कार्य को कुशलतापूर्वक हल करने के लिए वर्कफ़्लो में लचीलेपन की आवश्यकता है?

|

||||

यदि पूर्व-निर्धारित वर्कफ़्लो बहुत बार विफल होता है, तो इसका मतलब है कि आपको अधिक लचीलेपन की आवश्यकता है।

|

||||

|

||||

आइए एक उदाहरण लेते हैं: मान लीजिए आप एक ऐप बना रहे हैं जो एक सर्फिंग ट्रिप वेबसाइट पर ग्राहक अनुरोधों को संभालता है।

|

||||

|

||||

आप पहले से जान सकते हैं कि अनुरोध 2 में से किसी एक श्रेणी में आएंगे (उपयोगकर्ता की पसंद के आधार पर), और आपके पास इन 2 मामलों में से प्रत्येक के लिए एक पूर्व-निर्धारित वर्कफ़्लो है।

|

||||

|

||||

1. ट्रिप के बारे में कुछ जानकारी चाहिए? ⇒ उन्हें अपने नॉलेज बेस में खोज करने के लिए एक सर्च बार तक पहुंच दें

|

||||

2. सेल्स टीम से बात करना चाहते हैं? ⇒ उन्हें एक संपर्क फॉर्म में टाइप करने दें।

|

||||

|

||||

यदि वह निर्धारणात्मक वर्कफ़्लो सभी प्रश्नों के लिए फिट बैठता है, तो बेशक बस सब कुछ कोड करें! यह आपको एक 100% विश्वसनीय सिस्टम देगा और एलएलएम द्वारा अनपेक्षित कार्यप्रवाह में हस्तक्षेप करने से त्रुटियों का कोई जोखिम नहीं होगा। साधारणता और मजबूती के लिए, सलाह दी जाती है कि एजेंटिक व्यवहार का उपयोग न किया जाए।

|

||||

|

||||

लेकिन क्या होगा अगर वर्कफ़्लो को पहले से इतनी अच्छी तरह से निर्धारित नहीं किया जा सकता?

|

||||

|

||||

उदाहरण के लिए, एक उपयोगकर्ता पूछना चाहता है: `"मैं सोमवार को आ सकता हूं, लेकिन मैं अपना पासपोर्ट भूल गया जिससे मुझे बुधवार तक देर हो सकती है, क्या आप मुझे और मेरी चीजों को मंगलवार सुबह सर्फ करने ले जा सकते हैं, क्या मुझे कैंसलेशन इंश्योरेंस मिल सकता है?"` यह प्रश्न कई कारकों पर निर्भर करता है, और शायद ऊपर दिए गए पूर्व-निर्धारित मानदंडों में से कोई भी इस अनुरोध के लिए पर्याप्त नहीं होगा।

|

||||

|

||||

यदि पूर्व-निर्धारित वर्कफ़्लो बहुत बार विफल होता है, तो इसका मतलब है कि आपको अधिक लचीलेपन की आवश्यकता है।

|

||||

|

||||

यहीं पर एक एजेंटिक सेटअप मदद करता है।

|

||||

|

||||

ऊपर दिए गए उदाहरण में, आप बस एक मल्टी-स्टेप agent बना सकते हैं जिसके पास मौसम पूर्वानुमान के लिए एक मौसम API, यात्रा की दूरी जानने के लिए के लिए Google Maps API, एक कर्मचारी उपलब्धता डैशबोर्ड और आपके नॉलेज बेस पर एक RAG सिस्टम तक पहुंच है।

|

||||

|

||||

हाल ही तक, कंप्यूटर प्रोग्राम पूर्व-निर्धारित वर्कफ़्लो तक सीमित थे, if/else स्विच का

|

||||

ढेर लगाकार जटिलता को संभालने का प्रयास कर रहे थे। वे बेहद संकीर्ण कार्यों पर केंद्रित थे, जैसे "इन संख्याओं का योग निकालें" या "इस ग्राफ़ में सबसे छोटा रास्ता खोजें"। लेकिन वास्तव में, अधिकांश वास्तविक जीवन के कार्य, जैसे ऊपर दिया गया हमारा यात्रा उदाहरण, पूर्व-निर्धारित वर्कफ़्लो में फिट नहीं होते हैं। एजेंटिक सिस्टम प्रोग्राम के लिए वास्तविक दुनिया के कार्यों की विशाल दुनिया खोलते हैं!

|

||||

|

||||

## क्यों `smolagents`?

|

||||

|

||||

कुछ लो-लेवल एजेंटिक उपयोग के मामलों के लिए, जैसे चेन या राउटर, आप सभी कोड खुद लिख सकते हैं। आप इस तरह से बहुत बेहतर होंगे, क्योंकि यह आपको अपने सिस्टम को बेहतर ढंग से नियंत्रित और समझने की अनुमति देगा।

|

||||

|

||||

लेकिन जैसे ही आप अधिक जटिल व्यवहारों की ओर बढ़ते हैं जैसे कि LLM को एक फ़ंक्शन कॉल करने देना (यह "tool calling" है) या LLM को एक while लूप चलाने देना ("multi-step agent"), कुछ एब्सट्रैक्शन्स की आवश्यकता होती है:

|

||||

- टूल कॉलिंग के लिए, आपको एजेंट के आउटपुट को पार्स करने की आवश्यकता होती है, इसलिए इस आउटपुट को एक पूर्व-निर्धारित प्रारूप की आवश्यकता होती है जैसे "विचार: मुझे 'get_weather' टूल कॉल करना चाहिए। क्रिया: get_weather(Paris)।", जिसे आप एक पूर्व-निर्धारित फ़ंक्शन के साथ पार्स करते हैं, और LLM को दिए गए सिस्टम प्रॉम्प्ट को इस प्रारूप के बारे में सूचित करना चाहिए।

|

||||

- एक मल्टी-स्टेप एजेंट के लिए जहां LLM आउटपुट लूप को निर्धारित करता है, आपको पिछले लूप इटरेशन में क्या हुआ इसके आधार पर LLM को एक अलग प्रॉम्प्ट देने की आवश्यकता होती है: इसलिए आपको किसी प्रकार की मेमोरी की आवश्यकता होती है।

|

||||

|

||||

इन दो उदाहरणों के साथ, हमने पहले ही कुछ चीजों की आवश्यकता का पता लगा लिया:

|

||||

|

||||

- बेशक, एक LLM जो सिस्टम को पावर देने वाले इंजन के रूप में कार्य करता है

|

||||

- एजेंट द्वारा एक्सेस किए जा सकने वाले टूल्स की एक सूची

|

||||

- एक पार्सर जो LLM आउटपुट से टूल कॉल को निकालता है

|

||||

- एक सिस्टम प्रोम्प्ट जो पार्सर के साथ सिंक्रनाइज़ होता है

|

||||

- एक मेमोरी

|

||||

|

||||

लेकिन रुकिए, चूंकि हम निर्णयों में LLM को जगह देते हैं, निश्चित रूप से वे गलतियां करेंगे: इसलिए हमें एरर लॉगिंग और पुनः प्रयास तंत्र की आवश्यकता है।

|

||||

|

||||

ये सभी तत्व एक अच्छे कामकाजी सिस्टम बनाने के लिए एक-दूसरे से घनिष्ठ रूप से जुड़े हुए हैं। यही कारण है कि हमने तय किया कि इन सभी चीजों को एक साथ काम करने के लिए बुनियादी निर्माण ब्लॉक्स की आवश्यकता है।

|

||||

|

||||

## कोड Agents

|

||||

|

||||

एक मल्टी-स्टेप एजेंट में, प्रत्येक चरण पर, LLM बाहरी टूल्स को कुछ कॉल के रूप में एक क्रिया लिख सकता है। इन क्रियाओं को लिखने के लिए एक सामान्य स्वरूप (Anthropic, OpenAI और कई अन्य द्वारा उपयोग किया जाता है) आमतौर पर "टूल्स के नाम और उपयोग करने के लिए तर्कों के JSON के रूप में क्रियाएं लिखने" के विभिन्न रूप होते हैं, जिन्हें आप फिर पार्स करते हैं यह जानने के लिए कि कौन सा टूल किन तर्कों के साथ निष्पादित करना है"।

|

||||

|

||||

[कई](https://huggingface.co/papers/2402.01030) [शोध](https://huggingface.co/papers/2411.01747) [पत्रों](https://huggingface.co/papers/2401.00812) ने दिखाया है कि कोड में टूल कॉलिंग LLM का होना बहुत बेहतर है।

|

||||

|

||||

इसका कारण बस यह है कि *हमने अपनी कोड भाषाओं को विशेष रूप से कंप्यूटर द्वारा किए गए कार्यों को व्यक्त करने का सर्वोत्तम संभव तरीका बनाने के लिए तैयार किया*। यदि JSON स्निपेट्स बेहतर अभिव्यक्ति होते, तो JSON शीर्ष प्रोग्रामिंग भाषा होती और प्रोग्रामिंग नरक में होती।

|

||||

|

||||

नीचे दी गई छवि, [Executable Code Actions Elicit Better LLM Agents](https://huggingface.co/papers/2402.01030) से ली गई है, जो कोड में क्रियाएं लिखने के कुछ फायदे दर्शाती है:

|

||||

|

||||

<img src="https://huggingface.co/datasets/huggingface/documentation-images/resolve/main/transformers/code_vs_json_actions.png">

|

||||

|

||||

JSON जैसे स्निपेट्स की बजाय कोड में क्रियाएं लिखने से बेहतर प्राप्त होता है:

|

||||

|

||||

- **कम्पोजेबिलिटी:** क्या आप JSON क्रियाओं को एक-दूसरे के भीतर नेस्ट कर सकते हैं, या बाद में पुन: उपयोग करने के लिए JSON क्रियाओं का एक सेट परिभाषित कर सकते हैं, उसी तरह जैसे आप बस एक पायथन फंक्शन परिभाषित कर सकते हैं?

|

||||

- **ऑब्जेक्ट प्रबंधन:** आप `generate_image` जैसी क्रिया के आउटपुट को JSON में कैसे स्टोर करते हैं?

|

||||

- **सामान्यता:** कोड को सरल रूप से कुछ भी व्यक्त करने के लिए बनाया गया है जो आप कंप्यूटर से करवा सकते हैं।

|

||||

- **LLM प्रशिक्षण डेटा में प्रतिनिधित्व:** बहुत सारी गुणवत्तापूर्ण कोड क्रियाएं पहले से ही LLM के ट्रेनिंग डेटा में शामिल हैं जिसका मतलब है कि वे इसके लिए पहले से ही प्रशिक्षित हैं!

|

||||

|

|

@ -0,0 +1,47 @@

|

|||

<!--Copyright 2024 The HuggingFace Team. All rights reserved.

|

||||

|

||||

Licensed under the Apache License, Version 2.0 (the "License"); you may not use this file except in compliance with

|

||||

the License. You may obtain a copy of the License at

|

||||

|

||||

http://www.apache.org/licenses/LICENSE-2.0

|

||||

|

||||

Unless required by applicable law or agreed to in writing, software distributed under the License is distributed on

|

||||

an "AS IS" BASIS, WITHOUT WARRANTIES OR CONDITIONS OF ANY KIND, either express or implied. See the License for the

|

||||

specific language governing permissions and limitations under the License.

|

||||

|

||||

⚠️ Note that this file is in Markdown but contain specific syntax for our doc-builder (similar to MDX) that may not be

|

||||

rendered properly in your Markdown viewer.

|

||||

|

||||

-->

|

||||

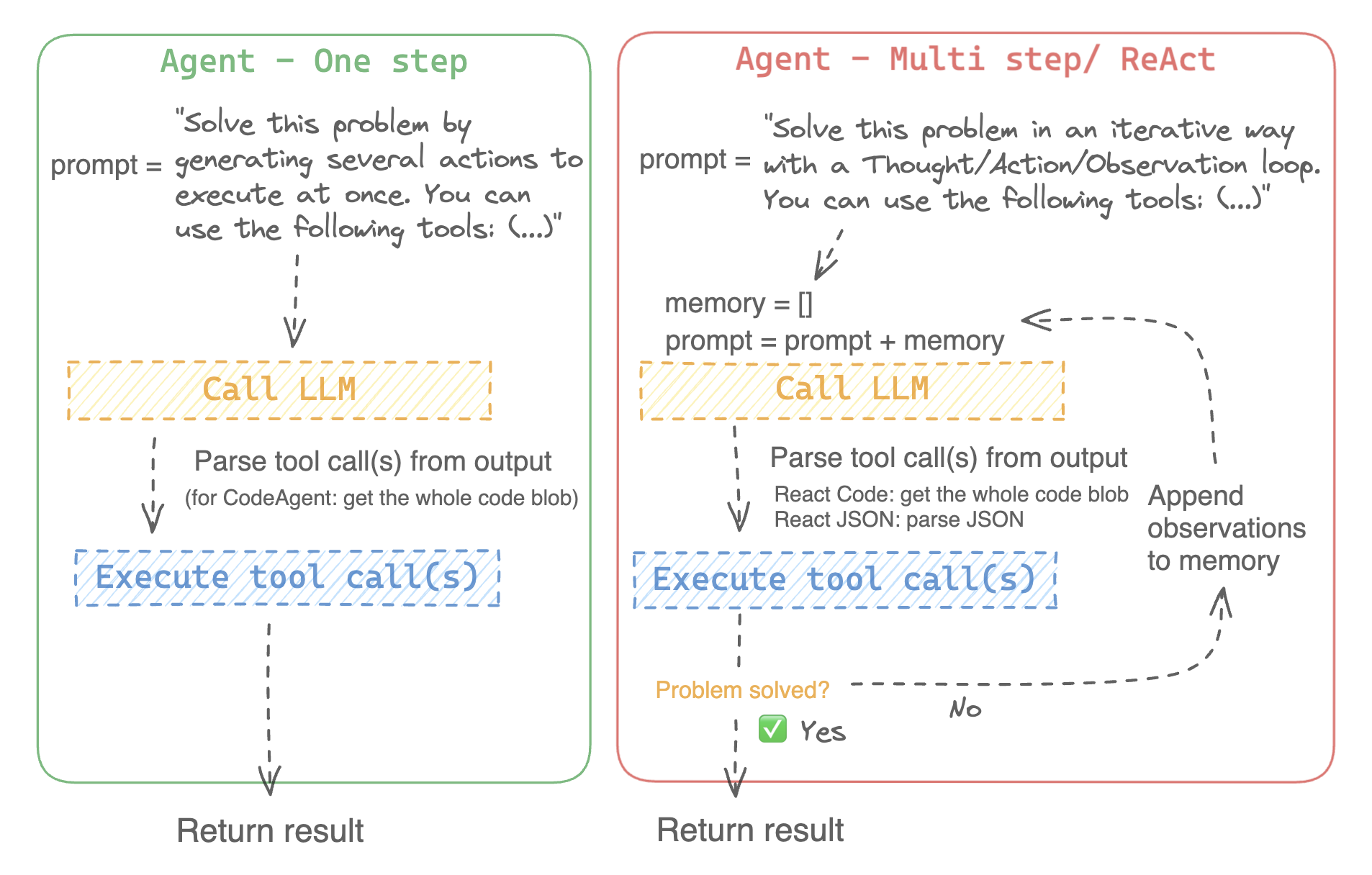

# मल्टी-स्टेप एजेंट्स कैसे काम करते हैं?

|

||||

|

||||

ReAct फ्रेमवर्क ([Yao et al., 2022](https://huggingface.co/papers/2210.03629)) वर्तमान में एजेंट्स बनाने का मुख्य दृष्टिकोण है।

|

||||

|

||||

नाम दो शब्दों, "Reason" (तर्क) और "Act" (क्रिया) के संयोजन पर आधारित है। वास्तव में, इस आर्किटेक्चर का पालन करने वाले एजेंट अपने कार्य को उतने चरणों में हल करेंगे जितने आवश्यक हों, प्रत्येक चरण में एक Reasoning कदम होगा, फिर एक Action कदम होगा, जहाँ यह टूल कॉल्स तैयार करेगा जो उसे कार्य को हल करने के करीब ले जाएंगे।

|

||||

|

||||

ReAct प्रक्रिया में पिछले चरणों की मेमोरी रखना शामिल है।

|

||||

|

||||

> [!TIP]

|

||||

> मल्टी-स्टेप एजेंट्स के बारे में अधिक जानने के लिए [Open-source LLMs as LangChain Agents](https://huggingface.co/blog/open-source-llms-as-agents) ब्लॉग पोस्ट पढ़ें।

|

||||

|

||||

यहाँ एक वीडियो ओवरव्यू है कि यह कैसे काम करता है:

|

||||

|

||||

<div class="flex justify-center">

|

||||

<img

|

||||

class="block dark:hidden"

|

||||

src="https://huggingface.co/datasets/huggingface/documentation-images/resolve/main/transformers/Agent_ManimCE.gif"

|

||||

/>

|

||||

<img

|

||||

class="hidden dark:block"

|

||||

src="https://huggingface.co/datasets/huggingface/documentation-images/resolve/main/transformers/Agent_ManimCE.gif"

|

||||

/>

|

||||

</div>

|

||||

|

||||

|

||||

|

||||

हम दो प्रकार के ToolCallingAgent को लागू करते हैं:

|

||||

- [`ToolCallingAgent`] अपने आउटपुट में टूल कॉल को JSON के रूप में जनरेट करता है।

|

||||

- [`CodeAgent`] ToolCallingAgent का एक नया प्रकार है जो अपने टूल कॉल को कोड के ब्लॉब्स के रूप में जनरेट करता है, जो उन LLM के लिए वास्तव में अच्छी तरह काम करता है जिनका कोडिंग प्रदर्शन मजबूत है।

|

||||

|

||||

> [!TIP]

|

||||

> हम एजेंट्स को वन-शॉट में चलाने का विकल्प भी प्रदान करते हैं: बस एजेंट को लॉन्च करते समय `single_step=True` पास करें, जैसे `agent.run(your_task, single_step=True)`

|

||||

|

|

@ -0,0 +1,199 @@

|

|||

<!--Copyright 2024 The HuggingFace Team. All rights reserved.

|

||||

|

||||

Licensed under the Apache License, Version 2.0 (the "License"); you may not use this file except in compliance with

|

||||

the License. You may obtain a copy of the License at

|

||||

|

||||

http://www.apache.org/licenses/LICENSE-2.0

|

||||

|

||||

Unless required by applicable law or agreed to in writing, software distributed under the License is distributed on

|

||||

an "AS IS" BASIS, WITHOUT WARRANTIES OR CONDITIONS OF ANY KIND, either express or implied. See the License for the

|

||||

specific language governing permissions and limitations under the License.

|

||||

|

||||

⚠️ Note that this file is in Markdown but contain specific syntax for our doc-builder (similar to MDX) that may not be

|

||||

rendered properly in your Markdown viewer.

|

||||

|

||||

-->

|

||||

# मल्टी-एजेंट सिस्टम का आयोजन करें 🤖🤝🤖

|

||||

|

||||

[[open-in-colab]]

|

||||

|

||||

इस नोटबुक में हम एक **मल्टी-एजेंट वेब ब्राउज़र बनाएंगे: एक एजेंटिक सिस्टम जिसमें कई एजेंट वेब का उपयोग करके समस्याओं को हल करने के लिए सहयोग करते हैं!**

|

||||

|

||||

यह एक सरल संरचना होगी, जो प्रबंधित वेब खोज एजेंट को रैप करने के लिए `ManagedAgent` ऑब्जेक्ट का उपयोग करता है:

|

||||

|

||||

```

|

||||

+----------------+

|

||||

| Manager agent |

|

||||

+----------------+

|

||||

|

|

||||

_______________|______________

|

||||

| |

|

||||

Code interpreter +--------------------------------+

|

||||

tool | Managed agent |

|

||||

| +------------------+ |

|

||||

| | Web Search agent | |

|

||||

| +------------------+ |

|

||||

| | | |

|

||||

| Web Search tool | |

|

||||

| Visit webpage tool |

|

||||

+--------------------------------+

|

||||

```

|

||||

आइए इस सिस्टम को सेट करें।

|

||||

|

||||

आवश्यक डिपेंडेंसी इंस्टॉल करने के लिए नीचे दी गई लाइन चलाएं:

|

||||

|

||||

```

|

||||

!pip install markdownify duckduckgo-search smolagents --upgrade -q

|

||||

```

|

||||

|

||||

HF Inference API को कॉल करने के लिए लॉगिन करें:

|

||||

|

||||

```

|

||||

from huggingface_hub import login

|

||||

|

||||

login()

|

||||

```

|

||||

|

||||

⚡️ हमारा एजेंट [Qwen/Qwen2.5-Coder-32B-Instruct](https://huggingface.co/Qwen/Qwen2.5-Coder-32B-Instruct) द्वारा संचालित होगा जो `HfApiModel` क्लास का उपयोग करता है जो HF के Inference API का उपयोग करता है: Inference API किसी भी OS मॉडल को जल्दी और आसानी से चलाने की अनुमति देता है।

|

||||

|

||||

_नोट:_ The Inference API विभिन्न मानदंडों के आधार पर मॉडल होस्ट करता है, और डिप्लॉय किए गए मॉडल बिना पूर्व सूचना के अपडेट या बदले जा सकते हैं। इसके बारे में अधिक जानें [यहां](https://huggingface.co/docs/api-inference/supported-models)।

|

||||

|

||||

```py

|

||||

model_id = "Qwen/Qwen2.5-Coder-32B-Instruct"

|

||||

```

|

||||

|

||||

## 🔍 एक वेब सर्च टूल बनाएं

|

||||

|

||||

वेब ब्राउज़िंग के लिए, हम पहले से मौजूद [`DuckDuckGoSearchTool`](https://github.com/huggingface/smolagents/blob/main/src/smolagents/default_tools.py#L151-L176) टूल का उपयोग कर सकते हैं जो Google search के समान सुविधा प्रदान करता है।

|

||||

|

||||

लेकिन फिर हमें `DuckDuckGoSearchTool` द्वारा खोजे गए पेज को देखने में भी सक्षम होने की आवश्यकता होगी।

|

||||

ऐसा करने के लिए, हम लाइब्रेरी के बिल्ट-इन `VisitWebpageTool` को इम्पोर्ट कर सकते हैं, लेकिन हम इसे फिर से बनाएंगे यह देखने के लिए कि यह कैसे किया जाता है।

|

||||

|

||||

तो आइए `markdownify` का उपयोग करके शुरू से अपना `VisitWebpageTool` टूल बनाएं।

|

||||

|

||||

```py

|

||||

import re

|

||||

import requests

|

||||

from markdownify import markdownify

|

||||

from requests.exceptions import RequestException

|

||||

from smolagents import tool

|

||||

|

||||

|

||||

@tool

|

||||

def visit_webpage(url: str) -> str:

|

||||

"""Visits a webpage at the given URL and returns its content as a markdown string.

|

||||

|

||||

Args:

|

||||

url: The URL of the webpage to visit.

|

||||

|

||||

Returns:

|

||||

The content of the webpage converted to Markdown, or an error message if the request fails.

|

||||

"""

|

||||

try:

|

||||

# Send a GET request to the URL

|

||||

response = requests.get(url)

|

||||

response.raise_for_status() # Raise an exception for bad status codes

|

||||

|

||||

# Convert the HTML content to Markdown

|

||||

markdown_content = markdownify(response.text).strip()

|

||||

|

||||

# Remove multiple line breaks

|

||||

markdown_content = re.sub(r"\n{3,}", "\n\n", markdown_content)

|

||||

|

||||

return markdown_content

|

||||

|

||||

except RequestException as e:

|

||||

return f"Error fetching the webpage: {str(e)}"

|

||||

except Exception as e:

|

||||

return f"An unexpected error occurred: {str(e)}"

|

||||

```

|

||||

|

||||

ठीक है, अब चलिए हमारे टूल को टेस्ट करें!

|

||||

|

||||

```py

|

||||

print(visit_webpage("https://en.wikipedia.org/wiki/Hugging_Face")[:500])

|

||||

```

|

||||

|

||||

## हमारी मल्टी-एजेंट सिस्टम का निर्माण करें 🤖🤝🤖

|

||||

|

||||

अब जब हमारे पास सभी टूल्स `search` और `visit_webpage` हैं, हम उनका उपयोग वेब एजेंट बनाने के लिए कर सकते हैं।

|

||||

|

||||

इस एजेंट के लिए कौन सा कॉन्फ़िगरेशन चुनें?

|

||||

- वेब ब्राउज़िंग एक सिंगल-टाइमलाइन टास्क है जिसे समानांतर टूल कॉल की आवश्यकता नहीं है, इसलिए JSON टूल कॉलिंग इसके लिए अच्छी तरह काम करती है। इसलिए हम `JsonAgent` चुनते हैं।

|

||||

- साथ ही, चूंकि कभी-कभी वेब सर्च में सही उत्तर खोजने से पहले कई पेजों की सर्च करने की आवश्यकता होती है, हम `max_steps` को बढ़ाकर 10 करना पसंद करते हैं।

|

||||

|

||||

```py

|

||||

from smolagents import (

|

||||

CodeAgent,

|

||||

ToolCallingAgent,

|

||||

HfApiModel,

|

||||

ManagedAgent,

|

||||

DuckDuckGoSearchTool,

|

||||

LiteLLMModel,

|

||||

)

|

||||

|

||||

model = HfApiModel(model_id)

|

||||

|

||||

web_agent = ToolCallingAgent(

|

||||

tools=[DuckDuckGoSearchTool(), visit_webpage],

|

||||

model=model,

|

||||

max_steps=10,

|

||||

)

|

||||

```

|

||||

|

||||

फिर हम इस एजेंट को एक `ManagedAgent` में रैप करते हैं जो इसे इसके मैनेजर एजेंट द्वारा कॉल करने योग्य बनाएगा।

|

||||

|

||||

```py

|

||||

managed_web_agent = ManagedAgent(

|

||||

agent=web_agent,

|

||||

name="search",

|

||||

description="Runs web searches for you. Give it your query as an argument.",

|

||||

)

|

||||

```

|

||||

|

||||

अंत में हम एक मैनेजर एजेंट बनाते हैं, और इनिशियलाइजेशन पर हम अपने मैनेज्ड एजेंट को इसके `managed_agents` आर्गुमेंट में पास करते हैं।

|

||||

|

||||

चूंकि यह एजेंट योजना बनाने और सोचने का काम करता है, उन्नत तर्क लाभदायक होगा, इसलिए `CodeAgent` सबसे अच्छा विकल्प होगा।

|

||||

|

||||

साथ ही, हम एक ऐसा प्रश्न पूछना चाहते हैं जिसमें वर्तमान वर्ष और अतिरिक्त डेटा गणना शामिल है: इसलिए आइए `additional_authorized_imports=["time", "numpy", "pandas"]` जोड़ें, यदि एजेंट को इन पैकेजों की आवश्यकता हो।

|

||||

|

||||

```py

|

||||

manager_agent = CodeAgent(

|

||||

tools=[],

|

||||

model=model,

|

||||

managed_agents=[managed_web_agent],

|

||||

additional_authorized_imports=["time", "numpy", "pandas"],

|

||||

)

|

||||

```

|

||||

|

||||

बस इतना ही! अब चलिए हमारे सिस्टम को चलाते हैं! हम एक ऐसा प्रश्न चुनते हैं जिसमें गणना और शोध दोनों की आवश्यकता है।

|

||||

|

||||

```py

|

||||

answer = manager_agent.run("If LLM training continues to scale up at the current rhythm until 2030, what would be the electric power in GW required to power the biggest training runs by 2030? What would that correspond to, compared to some countries? Please provide a source for any numbers used.")

|

||||

```

|

||||

|

||||

We get this report as the answer:

|

||||

```

|

||||

Based on current growth projections and energy consumption estimates, if LLM trainings continue to scale up at the

|

||||

current rhythm until 2030:

|

||||

|

||||

1. The electric power required to power the biggest training runs by 2030 would be approximately 303.74 GW, which

|

||||

translates to about 2,660,762 GWh/year.

|

||||

|

||||

2. Comparing this to countries' electricity consumption:

|

||||

- It would be equivalent to about 34% of China's total electricity consumption.

|

||||

- It would exceed the total electricity consumption of India (184%), Russia (267%), and Japan (291%).

|

||||

- It would be nearly 9 times the electricity consumption of countries like Italy or Mexico.

|

||||

|

||||

3. Source of numbers:

|

||||

- The initial estimate of 5 GW for future LLM training comes from AWS CEO Matt Garman.

|

||||

- The growth projection used a CAGR of 79.80% from market research by Springs.

|

||||

- Country electricity consumption data is from the U.S. Energy Information Administration, primarily for the year

|

||||

2021.

|

||||

```

|

||||

|

||||

लगता है कि यदि [स्केलिंग हाइपोथिसिस](https://gwern.net/scaling-hypothesis) सत्य बनी रहती है तो हमें कुछ बड़े पावरप्लांट्स की आवश्यकता होगी।

|

||||

|

||||

हमारे एजेंट्स ने कार्य को हल करने के लिए कुशलतापूर्वक सहयोग किया! ✅

|

||||

|

||||

💡 आप इस ऑर्केस्ट्रेशन को आसानी से अधिक एजेंट्स में विस्तारित कर सकते हैं: एक कोड एक्जीक्यूशन करता है, एक वेब सर्च करता है, एक फाइल लोडिंग को संभालता है।

|

||||

|

|

@ -0,0 +1,156 @@

|

|||

<!--Copyright 2024 The HuggingFace Team. All rights reserved.

|

||||

|

||||

Licensed under the Apache License, Version 2.0 (the "License"); you may not use this file except in compliance with

|

||||

the License. You may obtain a copy of the License at

|

||||

|

||||

http://www.apache.org/licenses/LICENSE-2.0

|

||||

|

||||

Unless required by applicable law or agreed to in writing, software distributed under the License is distributed on

|

||||

an "AS IS" BASIS, WITHOUT WARRANTIES OR CONDITIONS OF ANY KIND, either express or implied. See the License for the

|

||||

specific language governing permissions and limitations under the License.

|

||||

|

||||

⚠️ Note that this file is in Markdown but contain specific syntax for our doc-builder (similar to MDX) that may not be

|

||||

rendered properly in your Markdown viewer.

|

||||

|

||||

-->

|

||||

# एजेंटिक RAG

|

||||

|

||||

[[open-in-colab]]

|

||||

|

||||

रिट्रीवल-ऑगमेंटेड-जनरेशन (RAG) है "एक यूजर के प्रश्न का उत्तर देने के लिए LLM का उपयोग करना, लेकिन उत्तर को एक नॉलेज बेस से प्राप्त जानकारी पर आधारित करना"। इसमें वैनिला या फाइन-ट्यून्ड LLM का उपयोग करने की तुलना में कई फायदे हैं: कुछ नाम लेने के लिए, यह उत्तर को सत्य तथ्यों पर आधारित करने और काल्पनिक बातों को कम करने की अनुमति देता है, यह LLM को डोमेन-विशिष्ट ज्ञान प्रदान करने की अनुमति देता है, और यह नॉलेज बेस से जानकारी तक पहुंच का सूक्ष्म नियंत्रण प्रदान करता है।

|

||||

|

||||

लेकिन वैनिला RAG की सीमाएं हैं, सबसे महत्वपूर्ण ये दो:

|

||||

- यह केवल एक रिट्रीवल स्टेप करता है: यदि परिणाम खराब हैं, तो जनरेशन भी बदले में खराब होगा।

|

||||

- सिमेंटिक समानता की गणना यूजर के प्रश्न को संदर्भ के रूप में करके की जाती है, जो अनुकूल नहीं हो सकती: उदाहरण के लिए, यूजर का प्रश्न अक्सर एक सवाल होगा, जबकि सही उत्तर देने वाला डॉक्यूमेंट सकारात्मक स्वर में हो सकता है, और इसका समानता स्कोर अन्य स्रोत दस्तावेज़ों की तुलना में कम हो सकता है, जो प्रश्नवाचक स्वर में हो सकते हैं। इससे संबंधित जानकारी को चूकने का जोखिम होता है।

|

||||

|

||||

हम एक RAG एजेंट बनाकर इन समस्याओं को कम कर सकते हैं: बहुत सरल तरीके से, एक रिट्रीवर टूल से लैस एजेंट!

|

||||

|

||||

यह एजेंट करेगा: ✅ स्वयं क्वेरी तैयार करेगा और ✅ आवश्यकता पड़ने पर पुनः-प्राप्ति के लिए समीक्षा करेगा।

|

||||

|

||||

इसलिए यह सहज रूप से कुछ उन्नत RAG तकनीकों को प्राप्त कर लेना चाहिए!

|

||||

- सिमेंटिक खोज में सीधे यूजर क्वेरी का संदर्भ के रूप में उपयोग करने के बजाय, एजेंट स्वयं एक संदर्भ वाक्य तैयार करता है जो लक्षित डॉक्यूमेंट्स के करीब हो सकता है, जैसा कि [HyDE](https://huggingface.co/papers/2212.10496) में किया गया है।

|

||||

एजेंट जनरेट किए गए स्निपेट्स का उपयोग कर सकता है और आवश्यकता पड़ने पर पुनः-प्राप्ति कर सकता है, जैसा कि [Self-Query](https://docs.llamaindex.ai/en/stable/examples/evaluation/RetryQuery/) में किया गया है।

|

||||

|

||||

चलिए इस सिस्टम को बनाते हैं। 🛠️

|

||||

|

||||

आवश्यक डिपेंडेंसी इंस्टॉल करने के लिए नीचे दी गई लाइन चलाएं।

|

||||

```bash

|

||||

!pip install smolagents pandas langchain langchain-community sentence-transformers rank_bm25 --upgrade -q

|

||||

```

|

||||

HF Inference API को कॉल करने के लिए, आपको अपने एनवायरनमेंट वेरिएबल `HF_TOKEN` के रूप में एक वैध टोकन की आवश्यकता होगी।

|

||||

हम इसे लोड करने के लिए python-dotenv का उपयोग करते हैं।

|

||||

```py

|

||||

from dotenv import load_dotenv

|

||||

load_dotenv()

|

||||

```

|

||||

|

||||

हम पहले एक नॉलेज बेस लोड करते हैं जिस पर हम RAG को लागू करना चाहते हैं: यह डेटा सेट Hugging Face के कई लाइब्रेरी के डॉक्यूमेंट पृष्ठों का संकलन है, जिन्हें Markdown में स्टोर किया गया है। हम केवल `transformers` लाइब्रेरी के दस्तावेज़ों को रखेंगे।

|

||||

|

||||

फिर डेटासेट को प्रोसेस करके और इसे एक वेक्टर डेटाबेस में स्टोर करके नॉलेज बेस तैयार करें जिसे रिट्रीवर द्वारा उपयोग किया जाएगा।

|

||||

|

||||

हम [LangChain](https://python.langchain.com/docs/introduction/) का उपयोग करते हैं क्योंकि इसमें उत्कृष्ट वेक्टर डेटाबेस उपयोगिताएं हैं।

|

||||

|

||||

```py

|

||||

import datasets

|

||||

from langchain.docstore.document import Document

|

||||

from langchain.text_splitter import RecursiveCharacterTextSplitter

|

||||

from langchain_community.retrievers import BM25Retriever

|

||||

|

||||

knowledge_base = datasets.load_dataset("m-ric/huggingface_doc", split="train")

|

||||

knowledge_base = knowledge_base.filter(lambda row: row["source"].startswith("huggingface/transformers"))

|

||||

|

||||

source_docs = [

|

||||

Document(page_content=doc["text"], metadata={"source": doc["source"].split("/")[1]})

|

||||

for doc in knowledge_base

|

||||

]

|

||||

|

||||

text_splitter = RecursiveCharacterTextSplitter(

|

||||

chunk_size=500,

|

||||

chunk_overlap=50,

|

||||

add_start_index=True,

|

||||

strip_whitespace=True,

|

||||

separators=["\n\n", "\n", ".", " ", ""],

|

||||

)

|

||||

docs_processed = text_splitter.split_documents(source_docs)

|

||||

```

|

||||

|

||||

अब डॉक्यूमेंट्स तैयार हैं।

|

||||

|

||||

तो चलिए अपना एजेंटिक RAG सिस्टम बनाएं!

|

||||

|

||||

👉 हमें केवल एक RetrieverTool की आवश्यकता है जिसका उपयोग हमारा एजेंट नॉलेज बेस से जानकारी प्राप्त करने के लिए कर सकता है।

|

||||

|

||||

चूंकि हमें टूल के एट्रीब्यूट के रूप में एक vectordb जोड़ने की आवश्यकता है, हम सरल टूल कंस्ट्रक्टर को `@tool` डेकोरेटर के साथ सीधे उपयोग नहीं कर सकते: इसलिए हम [tools tutorial](../tutorials/tools) में हाइलाइट किए गए सेटअप का पालन करेंगे।

|

||||

|

||||

```py

|

||||

from smolagents import Tool

|

||||

|

||||

class RetrieverTool(Tool):

|

||||

name = "retriever"

|

||||

description = "Uses semantic search to retrieve the parts of transformers documentation that could be most relevant to answer your query."

|

||||

inputs = {

|

||||

"query": {

|

||||

"type": "string",

|

||||

"description": "The query to perform. This should be semantically close to your target documents. Use the affirmative form rather than a question.",

|

||||

}

|

||||

}

|

||||

output_type = "string"

|

||||

|

||||

def __init__(self, docs, **kwargs):

|

||||

super().__init__(**kwargs)

|

||||

self.retriever = BM25Retriever.from_documents(

|

||||

docs, k=10

|

||||

)

|

||||

|

||||

def forward(self, query: str) -> str:

|

||||

assert isinstance(query, str), "Your search query must be a string"

|

||||

|

||||

docs = self.retriever.invoke(

|

||||

query,

|

||||

)

|

||||

return "\nRetrieved documents:\n" + "".join(

|

||||

[

|

||||

f"\n\n===== Document {str(i)} =====\n" + doc.page_content

|

||||

for i, doc in enumerate(docs)

|

||||

]

|

||||

)

|

||||

|

||||

retriever_tool = RetrieverTool(docs_processed)

|

||||

```

|

||||

हमने BM25 का उपयोग किया है, जो एक क्लासिक रिट्रीवल विधि है, क्योंकि इसे सेटअप करना बहुत आसान है।

|

||||

रिट्रीवल सटीकता में सुधार करने के लिए, आप BM25 को डॉक्यूमेंट्स के लिए वेक्टर प्रतिनिधित्व का उपयोग करके सिमेंटिक खोज से बदल सकते हैं: इस प्रकार आप एक अच्छा एम्बेडिंग मॉडल चुनने के लिए [MTEB Leaderboard](https://huggingface.co/spaces/mteb/leaderboard) पर जा सकते हैं।

|

||||

|

||||

अब यह सीधा है कि एक एजेंट बनाया जाए जो इस `retriever_tool` का उपयोग करेगा!

|

||||

|

||||

|

||||

एजेंट को इनिशियलाइजेशन पर इन आर्गुमेंट्स की आवश्यकता होगी:

|

||||

- `tools`: टूल्स की एक सूची जिन्हें एजेंट कॉल कर सकेगा।

|

||||

- `model`: LLM जो एजेंट को पावर देता है।

|

||||

हमारा `model` एक कॉलेबल होना चाहिए जो इनपुट के रूप में संदेशों की एक सूची लेता है और टेक्स्ट लौटाता है। इसे एक stop_sequences आर्गुमेंट भी स्वीकार करने की आवश्यकता है जो बताता है कि जनरेशन कब रोकनी है। सुविधा के लिए, हम सीधे पैकेज में प्रदान की गई HfEngine क्लास का उपयोग करते हैं ताकि एक LLM इंजन मिल सके जो Hugging Face के Inference API को कॉल करता है।

|

||||

|

||||

और हम [meta-llama/Llama-3.3-70B-Instruct](meta-llama/Llama-3.3-70B-Instruct) का उपयोग llm इंजन के रूप में करते हैं क्योंकि:

|

||||

- इसमें लंबा 128k कॉन्टेक्स्ट है, जो लंबे स्रोत दस्तावेजों को प्रोसेस करने में मददगार है

|

||||

- यह हर समय HF के Inference API पर मुफ्त में उपलब्ध है!

|

||||

|

||||

_नोट:_ Inference API विभिन्न मानदंडों के आधार पर मॉडल होस्ट करता है, और डिप्लॉय किए गए मॉडल बिना पूर्व सूचना के अपडेट या बदले जा सकते हैं। इसके बारे में अधिक जानें [यहां](https://huggingface.co/docs/api-inference/supported-models) पढ़ें।

|

||||

|

||||

```py

|

||||

from smolagents import HfApiModel, CodeAgent

|

||||

|

||||

agent = CodeAgent(

|

||||

tools=[retriever_tool], model=HfApiModel("meta-llama/Llama-3.3-70B-Instruct"), max_steps=4, verbosity_level=2

|

||||

)

|

||||

```

|

||||

|

||||

CodeAgent को इनिशियलाइज करने पर, इसे स्वचालित रूप से एक डिफ़ॉल्ट सिस्टम प्रॉम्प्ट दिया गया है जो LLM इंजन को चरण-दर-चरण प्रोसेस करने और कोड स्निपेट्स के रूप में टूल कॉल जनरेट करने के लिए कहता है, लेकिन आप आवश्यकतानुसार इस प्रॉम्प्ट टेम्पलेट को अपने से बदल सकते हैं।

|

||||

|

||||

जब CodeAgent का `.run()` मेथड लॉन्च किया जाता है, तो एजेंट LLM इंजन को कॉल करने का कार्य करता है, और टूल कॉल्स को निष्पादित करता है, यह सब एक लूप में होता है, जो तब तक चलता है जब तक टूल final_answer के साथ अंतिम उत्तर के रूप में नहीं बुलाया जाता।

|

||||

|

||||

```py

|

||||

agent_output = agent.run("For a transformers model training, which is slower, the forward or the backward pass?")

|

||||

|

||||

print("Final output:")

|

||||

print(agent_output)

|

||||

```

|

||||

|

||||

|

||||

|

|

@ -0,0 +1,203 @@

|

|||

<!--Copyright 2024 The HuggingFace Team. All rights reserved.

|

||||

|

||||

Licensed under the Apache License, Version 2.0 (the "License"); you may not use this file except in compliance with

|

||||

the License. You may obtain a copy of the License at

|

||||

|

||||

http://www.apache.org/licenses/LICENSE-2.0

|

||||

|

||||

Unless required by applicable law or agreed to in writing, software distributed under the License is distributed on

|

||||

an "AS IS" BASIS, WITHOUT WARRANTIES OR CONDITIONS OF ANY KIND, either express or implied. See the License for the

|

||||

specific language governing permissions and limitations under the License.

|

||||

|

||||

⚠️ Note that this file is in Markdown but contain specific syntax for our doc-builder (similar to MDX) that may not be

|

||||

rendered properly in your Markdown viewer.

|

||||

|

||||

-->

|

||||

# Text-to-SQL

|

||||

|

||||

[[open-in-colab]]

|

||||

|

||||

इस ट्यूटोरियल में, हम देखेंगे कि कैसे `smolagents` का उपयोग करके एक एजेंट को SQL का उपयोग करने के लिए लागू किया जा सकता है।

|

||||

|

||||

> आइए सबसे महत्वपूर्ण प्रश्न से शुरू करें: इसे साधारण क्यों नहीं रखें और एक सामान्य text-to-SQL पाइपलाइन का उपयोग करें?

|

||||

|

||||

एक सामान्य text-to-SQL पाइपलाइन कमजोर होती है, क्योंकि उत्पन्न SQL क्वेरी गलत हो सकती है। इससे भी बुरी बात यह है कि क्वेरी गलत हो सकती है, लेकिन कोई एरर नहीं दिखाएगी, बल्कि बिना किसी अलार्म के गलत/बेकार आउटपुट दे सकती है।

|

||||

|

||||

|

||||

👉 इसके बजाय, एक एजेंट सिस्टम आउटपुट का गंभीरता से निरीक्षण कर सकता है और तय कर सकता है कि क्वेरी को बदलने की जरूरत है या नहीं, इस प्रकार इसे बेहतर प्रदर्शन में मदद मिलती है।

|

||||

|

||||

आइए इस एजेंट को बनाएं! 💪

|

||||

|

||||

पहले, हम SQL एनवायरनमेंट सेटअप करते हैं:

|

||||

```py

|

||||

from sqlalchemy import (

|

||||

create_engine,

|

||||

MetaData,

|

||||

Table,

|

||||

Column,

|

||||

String,

|

||||

Integer,

|

||||

Float,

|

||||

insert,

|

||||

inspect,

|

||||

text,

|

||||

)

|

||||

|

||||

engine = create_engine("sqlite:///:memory:")

|

||||

metadata_obj = MetaData()

|

||||

|

||||

# create city SQL table

|

||||

table_name = "receipts"

|

||||

receipts = Table(

|

||||

table_name,

|

||||

metadata_obj,

|

||||

Column("receipt_id", Integer, primary_key=True),

|

||||

Column("customer_name", String(16), primary_key=True),

|

||||

Column("price", Float),

|

||||

Column("tip", Float),

|

||||

)

|

||||

metadata_obj.create_all(engine)

|

||||

|

||||

rows = [

|

||||

{"receipt_id": 1, "customer_name": "Alan Payne", "price": 12.06, "tip": 1.20},

|

||||

{"receipt_id": 2, "customer_name": "Alex Mason", "price": 23.86, "tip": 0.24},

|

||||

{"receipt_id": 3, "customer_name": "Woodrow Wilson", "price": 53.43, "tip": 5.43},

|

||||

{"receipt_id": 4, "customer_name": "Margaret James", "price": 21.11, "tip": 1.00},

|

||||

]

|

||||

for row in rows:

|

||||

stmt = insert(receipts).values(**row)

|

||||

with engine.begin() as connection:

|

||||

cursor = connection.execute(stmt)

|

||||

```

|

||||

|

||||

### Agent बनाएं

|

||||

|

||||

अब आइए हमारी SQL टेबल को एक टूल द्वारा पुनर्प्राप्त करने योग्य बनाएं।

|

||||

|

||||

टूल का विवरण विशेषता एजेंट सिस्टम द्वारा LLM के prompt में एम्बेड किया जाएगा: यह LLM को टूल का उपयोग करने के बारे में जानकारी देता है। यहीं पर हम SQL टेबल का वर्णन करना चाहते हैं।

|

||||

|

||||

```py

|

||||

inspector = inspect(engine)

|

||||

columns_info = [(col["name"], col["type"]) for col in inspector.get_columns("receipts")]

|

||||

|

||||

table_description = "Columns:\n" + "\n".join([f" - {name}: {col_type}" for name, col_type in columns_info])

|

||||

print(table_description)

|

||||

```

|

||||

|

||||

```text

|

||||

Columns:

|

||||

- receipt_id: INTEGER

|

||||

- customer_name: VARCHAR(16)

|

||||

- price: FLOAT

|

||||

- tip: FLOAT

|

||||

```

|

||||

|

||||

अब आइए हमारा टूल बनाएं। इसे निम्नलिखित की आवश्यकता है: (अधिक जानकारी के लिए [टूल doc](../tutorials/tools) पढ़ें)

|

||||

- एक डॉकस्ट्रिंग जिसमें आर्ग्युमेंट्स की सूची वाला `Args:` भाग हो।

|

||||

- इनपुट और आउटपुट दोनों पर टाइप हिंट्स।

|

||||

|

||||

```py

|

||||

from smolagents import tool

|

||||

|

||||

@tool

|

||||

def sql_engine(query: str) -> str:

|

||||

"""

|

||||

Allows you to perform SQL queries on the table. Returns a string representation of the result.

|

||||

The table is named 'receipts'. Its description is as follows:

|

||||

Columns:

|

||||

- receipt_id: INTEGER

|

||||

- customer_name: VARCHAR(16)

|

||||

- price: FLOAT

|

||||

- tip: FLOAT

|

||||

|

||||

Args:

|

||||

query: The query to perform. This should be correct SQL.

|

||||

"""

|

||||

output = ""

|

||||

with engine.connect() as con:

|

||||

rows = con.execute(text(query))

|

||||

for row in rows:

|

||||

output += "\n" + str(row)

|

||||

return output

|

||||

```

|

||||

|

||||

अब आइए एक एजेंट बनाएं जो इस टूल का लाभ उठाता है।

|

||||

|

||||

हम `CodeAgent` का उपयोग करते हैं, जो smolagents का मुख्य एजेंट क्लास है: एक एजेंट जो कोड में एक्शन लिखता है और ReAct फ्रेमवर्क के अनुसार पिछले आउटपुट पर पुनरावृत्ति कर सकता है।

|

||||

|

||||

मॉडल वह LLM है जो एजेंट सिस्टम को संचालित करता है। `HfApiModel` आपको HF के Inference API का उपयोग करके LLM को कॉल करने की अनुमति देता है, या तो सर्वरलेस या डेडिकेटेड एंडपॉइंट के माध्यम से, लेकिन आप किसी भी प्रोप्राइटरी API का भी उपयोग कर सकते हैं।

|

||||

|

||||

```py

|

||||

from smolagents import CodeAgent, HfApiModel

|

||||

|

||||

agent = CodeAgent(

|

||||

tools=[sql_engine],

|

||||

model=HfApiModel("meta-llama/Meta-Llama-3.1-8B-Instruct"),

|

||||

)

|

||||

agent.run("Can you give me the name of the client who got the most expensive receipt?")

|

||||

```

|

||||

|

||||

### लेवल 2: टेबल जॉइन्स

|

||||

|

||||

अब आइए इसे और चुनौतीपूर्ण बनाएं! हम चाहते हैं कि हमारा एजेंट कई टेबल्स के बीच जॉइन को संभाल सके।

|

||||

|

||||

तो आइए हम प्रत्येक receipt_id के लिए वेटर्स के नाम रिकॉर्ड करने वाली एक दूसरी टेबल बनाते हैं!

|

||||

|

||||

```py

|

||||

table_name = "waiters"

|

||||

receipts = Table(

|

||||

table_name,

|

||||

metadata_obj,

|

||||

Column("receipt_id", Integer, primary_key=True),

|

||||

Column("waiter_name", String(16), primary_key=True),

|

||||

)

|

||||

metadata_obj.create_all(engine)

|

||||

|

||||

rows = [

|

||||

{"receipt_id": 1, "waiter_name": "Corey Johnson"},

|

||||

{"receipt_id": 2, "waiter_name": "Michael Watts"},

|

||||

{"receipt_id": 3, "waiter_name": "Michael Watts"},

|

||||

{"receipt_id": 4, "waiter_name": "Margaret James"},

|

||||

]

|

||||

for row in rows:

|

||||

stmt = insert(receipts).values(**row)

|

||||

with engine.begin() as connection:

|

||||

cursor = connection.execute(stmt)

|

||||

```

|

||||

चूंकि हमने टेबल को बदल दिया है, हम LLM को इस टेबल की जानकारी का उचित उपयोग करने देने के लिए इस टेबल के विवरण के साथ `SQLExecutorTool` को अपडेट करते हैं।

|

||||

|

||||

```py

|

||||

updated_description = """Allows you to perform SQL queries on the table. Beware that this tool's output is a string representation of the execution output.

|

||||

It can use the following tables:"""

|

||||

|

||||

inspector = inspect(engine)

|

||||

for table in ["receipts", "waiters"]:

|

||||

columns_info = [(col["name"], col["type"]) for col in inspector.get_columns(table)]

|

||||

|

||||

table_description = f"Table '{table}':\n"

|

||||

|

||||

table_description += "Columns:\n" + "\n".join([f" - {name}: {col_type}" for name, col_type in columns_info])

|

||||

updated_description += "\n\n" + table_description

|

||||

|

||||

print(updated_description)

|

||||

```

|

||||

चूंकि यह रिक्वेस्ट पिछले वाले से थोड़ी कठिन है, हम LLM इंजन को अधिक शक्तिशाली [Qwen/Qwen2.5-Coder-32B-Instruct](https://huggingface.co/Qwen/Qwen2.5-Coder-32B-Instruct) का उपयोग करने के लिए स्विच करेंगे!

|

||||

|

||||

```py

|

||||

sql_engine.description = updated_description

|

||||

|

||||

agent = CodeAgent(

|

||||

tools=[sql_engine],

|

||||

model=HfApiModel("Qwen/Qwen2.5-Coder-32B-Instruct"),

|

||||

)

|

||||

|

||||

agent.run("Which waiter got more total money from tips?")

|

||||

```

|

||||

यह सीधे काम करता है! सेटअप आश्चर्यजनक रूप से सरल था, है ना?

|

||||

|

||||

यह उदाहरण पूरा हो गया! हमने इन अवधारणाओं को छुआ है:

|

||||

- नए टूल्स का निर्माण।

|

||||

- टूल के विवरण को अपडेट करना।

|

||||

- एक मजबूत LLM में स्विच करने से एजेंट की तर्कशक्ति में मदद मिलती है।

|

||||

|

||||

✅ अब आप वह text-to-SQL सिस्टम बना सकते हैं जिसका आपने हमेशा सपना देखा है! ✨

|

||||

|

|

@ -0,0 +1,360 @@

|

|||

<!--Copyright 2024 The HuggingFace Team. All rights reserved.

|

||||

|

||||

Licensed under the Apache License, Version 2.0 (the "License"); you may not use this file except in compliance with

|

||||

the License. You may obtain a copy of the License at

|

||||

|

||||

http://www.apache.org/licenses/LICENSE-2.0

|

||||

|

||||

Unless required by applicable law or agreed to in writing, software distributed under the License is distributed on

|

||||

an "AS IS" BASIS, WITHOUT WARRANTIES OR CONDITIONS OF ANY KIND, either express or implied. See the License for the

|

||||

specific language governing permissions and limitations under the License.

|

||||

|

||||

⚠️ Note that this file is in Markdown but contain specific syntax for our doc-builder (similar to MDX) that may not be

|

||||

rendered properly in your Markdown viewer.

|

||||

|

||||

-->

|

||||

# Agents - गाइडेड टूर

|

||||

|

||||

[[open-in-colab]]

|

||||

|

||||

इस गाइडेड विजिट में, आप सीखेंगे कि एक एजेंट कैसे बनाएं, इसे कैसे चलाएं, और अपने यूज-केस के लिए बेहतर काम करने के लिए इसे कैसे कस्टमाइज़ करें।

|

||||

|

||||

### अपना Agent बनाना

|

||||

|

||||

एक मिनिमल एजेंट को इनिशियलाइज़ करने के लिए, आपको कम से कम इन दो आर्ग्यूमेंट्स की आवश्यकता है:

|

||||

|

||||

- `model`, आपके एजेंट को पावर देने के लिए एक टेक्स्ट-जनरेशन मॉडल - क्योंकि एजेंट एक सिंपल LLM से अलग है, यह एक सिस्टम है जो LLM को अपने इंजन के रूप में उपयोग करता है। आप इनमें से कोई भी विकल्प उपयोग कर सकते हैं:

|

||||

- [`TransformersModel`] `transformers` पाइपलाइन को पहले से इनिशियलाइज़ करता है जो `transformers` का उपयोग करके आपकी लोकल मशीन पर इन्फरेंस चलाने के लिए होता है।

|

||||

- [`HfApiModel`] अंदर से `huggingface_hub.InferenceClient` का लाभ उठाता है।

|

||||

- [`LiteLLMModel`] आपको [LiteLLM](https://docs.litellm.ai/) के माध्यम से 100+ अलग-अलग मॉडल्स को कॉल करने देता है!

|

||||

|

||||

- `tools`, `Tools` की एक लिस्ट जिसे एजेंट टास्क को हल करने के लिए उपयोग कर सकता है। यह एक खाली लिस्ट हो सकती है। आप ऑप्शनल आर्ग्यूमेंट `add_base_tools=True` को परिभाषित करके अपनी `tools` लिस्ट के ऊपर डिफ़ॉल्ट टूलबॉक्स भी जोड़ सकते हैं।

|

||||

|

||||

एक बार जब आपके पास ये दो आर्ग्यूमेंट्स, `tools` और `model` हैं, तो आप एक एजेंट बना सकते हैं और इसे चला सकते हैं। आप कोई भी LLM उपयोग कर सकते हैं, या तो [Hugging Face API](https://huggingface.co/docs/api-inference/en/index), [transformers](https://github.com/huggingface/transformers/), [ollama](https://ollama.com/), या [LiteLLM](https://www.litellm.ai/) के माध्यम से।

|

||||

|

||||

<hfoptions id="एक LLM चुनें">

|

||||

<hfoption id="Hugging Face API">

|

||||

|

||||

Hugging Face API टोकन के बिना उपयोग करने के लिए मुफ्त है, लेकिन फिर इसमें रेट लिमिटेशन होगी।

|

||||

|

||||

गेटेड मॉडल्स तक पहुंचने या PRO अकाउंट के साथ अपनी रेट लिमिट्स बढ़ाने के लिए, आपको एनवायरनमेंट वेरिएबल `HF_TOKEN` सेट करना होगा या `HfApiModel` के इनिशियलाइजेशन पर `token` वेरिएबल पास करना होगा।

|

||||

|

||||

```python

|

||||

from smolagents import CodeAgent, HfApiModel

|

||||

|

||||

model_id = "meta-llama/Llama-3.3-70B-Instruct"

|

||||

|

||||

model = HfApiModel(model_id=model_id, token="<YOUR_HUGGINGFACEHUB_API_TOKEN>")

|

||||

agent = CodeAgent(tools=[], model=model, add_base_tools=True)

|

||||

|

||||

agent.run(

|

||||

"Could you give me the 118th number in the Fibonacci sequence?",

|

||||

)

|

||||

```

|

||||

</hfoption>

|

||||

<hfoption id="Local Transformers Model">

|

||||

|

||||

```python

|

||||

from smolagents import CodeAgent, TransformersModel

|

||||

|

||||

model_id = "meta-llama/Llama-3.2-3B-Instruct"

|

||||

|

||||

model = TransformersModel(model_id=model_id)

|

||||

agent = CodeAgent(tools=[], model=model, add_base_tools=True)

|

||||

|

||||

agent.run(

|

||||

"Could you give me the 118th number in the Fibonacci sequence?",

|

||||

)

|

||||

```

|

||||

</hfoption>

|

||||

<hfoption id="OpenAI या Anthropic API">

|

||||

|

||||

`LiteLLMModel` का उपयोग करने के लिए, आपको एनवायरनमेंट वेरिएबल `ANTHROPIC_API_KEY` या `OPENAI_API_KEY` सेट करना होगा, या इनिशियलाइजेशन पर `api_key` वेरिएबल पास करना होगा।

|

||||

|

||||

```python

|

||||

from smolagents import CodeAgent, LiteLLMModel

|

||||

|

||||

model = LiteLLMModel(model_id="anthropic/claude-3-5-sonnet-latest", api_key="YOUR_ANTHROPIC_API_KEY") # Could use 'gpt-4o'

|

||||

agent = CodeAgent(tools=[], model=model, add_base_tools=True)

|

||||

|

||||

agent.run(

|

||||

"Could you give me the 118th number in the Fibonacci sequence?",

|

||||

)

|

||||

```

|

||||

</hfoption>

|

||||

<hfoption id="Ollama">

|

||||

|

||||

```python

|

||||

from smolagents import CodeAgent, LiteLLMModel

|

||||

|

||||

model = LiteLLMModel(

|

||||

model_id="ollama_chat/llama3.2", # This model is a bit weak for agentic behaviours though

|

||||

api_base="http://localhost:11434", # replace with 127.0.0.1:11434 or remote open-ai compatible server if necessary

|

||||

api_key="YOUR_API_KEY" # replace with API key if necessary

|

||||

num_ctx=8192 # ollama default is 2048 which will fail horribly. 8192 works for easy tasks, more is better. Check https://huggingface.co/spaces/NyxKrage/LLM-Model-VRAM-Calculator to calculate how much VRAM this will need for the selected model.

|

||||

)

|

||||

|

||||

agent = CodeAgent(tools=[], model=model, add_base_tools=True)

|

||||

|

||||

agent.run(

|

||||

"Could you give me the 118th number in the Fibonacci sequence?",

|

||||

)

|

||||

```

|

||||

</hfoption>

|

||||

</hfoptions>

|

||||

|

||||

#### CodeAgent और ToolCallingAgent

|

||||

|

||||

[`CodeAgent`] हमारा डिफ़ॉल्ट एजेंट है। यह हर स्टेप पर पायथन कोड स्निपेट्स लिखेगा और एक्जीक्यूट करेगा।

|

||||

|

||||

डिफ़ॉल्ट रूप से, एक्जीक्यूशन आपके लोकल एनवायरनमेंट में किया जाता है।

|

||||

यह सुरक्षित होना चाहिए क्योंकि केवल वही फ़ंक्शंस कॉल किए जा सकते हैं जो आपने प्रदान किए हैं (विशेष रूप से यदि यह केवल Hugging Face टूल्स हैं) और पूर्व-परिभाषित सुरक्षित फ़ंक्शंस जैसे `print` या `math` मॉड्यूल से फ़ंक्शंस, इसलिए आप पहले से ही सीमित हैं कि क्या एक्जीक्यूट किया जा सकता है।

|

||||

|

||||

पायथन इंटरप्रेटर डिफ़ॉल्ट रूप से सेफ लिस्ट के बाहर इम्पोर्ट की अनुमति नहीं देता है, इसलिए सबसे स्पष्ट अटैक समस्या नहीं होनी चाहिए।

|

||||

आप अपने [`CodeAgent`] के इनिशियलाइजेशन पर आर्ग्यूमेंट `additional_authorized_imports` में स्ट्रिंग्स की लिस्ट के रूप में अतिरिक्त मॉड्यूल्स को अधिकृत कर सकते हैं।

|

||||

|

||||

```py

|

||||

model = HfApiModel()

|

||||

agent = CodeAgent(tools=[], model=model, additional_authorized_imports=['requests', 'bs4'])

|

||||

agent.run("Could you get me the title of the page at url 'https://huggingface.co/blog'?")

|

||||

```

|

||||

|

||||

> [!WARNING]

|

||||

> LLM आर्बिट्ररी कोड जनरेट कर सकता है जो फिर एक्जीक्यूट किया जाएगा: कोई असुरक्षित इम्पोर्ट न जोड़ें!

|

||||

|

||||

एक्जीक्यूशन किसी भी कोड पर रुक जाएगा जो एक अवैध ऑपरेशन करने का प्रयास करता है या यदि एजेंट द्वारा जनरेट किए गए कोड में एक रेगुलर पायथन एरर है।

|

||||

|

||||

आप [E2B कोड एक्जीक्यूटर](https://e2b.dev/docs#what-is-e2-b) का उपयोग लोकल पायथन इंटरप्रेटर के बजाय कर सकते हैं, पहले [`E2B_API_KEY` एनवायरनमेंट वेरिएबल सेट करके](https://e2b.dev/dashboard?tab=keys) और फिर एजेंट इनिशियलाइजेशन पर `use_e2b_executor=True` पास करके।

|

||||

|

||||

> [!TIP]

|

||||

> कोड एक्जीक्यूशन के बारे में और जानें [इस ट्यूटोरियल में](tutorials/secure_code_execution)।

|

||||

|

||||

हम JSON-जैसे ब्लॉब्स के रूप में एक्शन लिखने के व्यापक रूप से उपयोग किए जाने वाले तरीके का भी समर्थन करते हैं: यह [`ToolCallingAgent`] है, यह बहुत कुछ [`CodeAgent`] की तरह ही काम करता है, बेशक `additional_authorized_imports` के बिना क्योंकि यह कोड एक्जीक्यूट नहीं करता।

|

||||

|

||||

```py

|

||||

from smolagents import ToolCallingAgent

|

||||

|

||||

agent = ToolCallingAgent(tools=[], model=model)

|

||||

agent.run("Could you get me the title of the page at url 'https://huggingface.co/blog'?")

|

||||

```

|

||||

|

||||

### एजेंट रन का निरीक्षण

|

||||

|

||||

रन के बाद क्या हुआ यह जांचने के लिए यहाँ कुछ उपयोगी एट्रिब्यूट्स हैं:

|

||||

- `agent.logs` एजेंट के फाइन-ग्रेन्ड लॉग्स को स्टोर करता है। एजेंट के रन के हर स्टेप पर, सब कुछ एक डिक्शनरी में स्टोर किया जाता है जो फिर `agent.logs` में जोड़ा जाता है।

|

||||

- `agent.write_inner_memory_from_logs()` चलाने से LLM के लिए एजेंट के लॉग्स की एक इनर मेमोरी बनती है, चैट मैसेज की लिस्ट के रूप में। यह मेथड लॉग के प्रत्येक स्टेप पर जाता है और केवल वही स्टोर करता है जिसमें यह एक मैसेज के रूप में रुचि रखता है: उदाहरण के लिए, यह सिस्टम प्रॉम्प्ट और टास्क को अलग-अलग मैसेज के रूप में सेव करेगा, फिर प्रत्येक स्टेप के लिए यह LLM आउटपुट को एक मैसेज के रूप में और टूल कॉल आउटपुट को दूसरे मैसेज के रूप में स्टोर करेगा।

|

||||

|

||||

## टूल्स

|

||||

|

||||

टूल एक एटॉमिक फ़ंक्शन है जिसे एजेंट द्वारा उपयोग किया जाता है। LLM द्वारा उपयोग किए जाने के लिए, इसे कुछ एट्रिब्यूट्स की भी आवश्यकता होती है जो इसकी API बनाते हैं और LLM को यह बताने के लिए उपयोग किए जाएंगे कि इस टूल को कैसे कॉल करें:

|

||||

- एक नाम

|

||||

- एक विवरण

|

||||

- इनपुट प्रकार और विवरण

|

||||

- एक आउटपुट प्रकार

|

||||

|

||||

आप उदाहरण के लिए [`PythonInterpreterTool`] को चेक कर सकते हैं: इसमें एक नाम, विवरण, इनपुट विवरण, एक आउटपुट प्रकार, और एक्शन करने के लिए एक `forward` मेथड है।

|

||||

|

||||

जब एजेंट इनिशियलाइज़ किया जाता है, टूल एट्रिब्यूट्स का उपयोग एक टूल विवरण जनरेट करने के लिए किया जाता है जो एजेंट के सिस्टम प्रॉम्प्ट में बेक किया जाता है। यह एजेंट को बताता है कि वह कौन से टूल्स उपयोग कर सकता है और क्यों।

|

||||

|

||||

### डिफ़ॉल्ट टूलबॉक्स

|

||||

|

||||

Transformers एजेंट्स को सशक्त बनाने के लिए एक डिफ़ॉल्ट टूलबॉक्स के साथ आता है, जिसे आप आर्ग्यूमेंट `add_base_tools = True` के साथ अपने एजेंट में इनिशियलाइजेशन पर जोड़ सकते हैं:

|

||||

|

||||

- **DuckDuckGo वेब सर्च**: DuckDuckGo ब्राउज़र का उपयोग करके वेब सर्च करता है।

|

||||

- **पायथन कोड इंटरप्रेटर**: आपका LLM जनरेटेड पायथन कोड एक सुरक्षित एनवायरनमेंट में चलाता है। यह टूल [`ToolCallingAgent`] में केवल तभी जोड़ा जाएगा जब आप इसे `add_base_tools=True` के साथ इनिशियलाइज़ करते हैं, क्योंकि कोड-बेस्ड एजेंट पहले से ही नेटिव रूप से पायथन कोड एक्जीक्यूट कर सकता है

|

||||

- **ट्रांसक्राइबर**: Whisper-Turbo पर बनाया गया एक स्पीच-टू-टेक्स्ट पाइपलाइन जो ऑडियो को टेक्स्ट में ट्रांसक्राइब करता है।

|

||||

|

||||

आप मैन्युअल रूप से एक टूल का उपयोग उसके आर्ग्यूमेंट्स के साथ कॉल करके कर सकते हैं।

|

||||

|

||||

```python

|

||||

from smolagents import DuckDuckGoSearchTool

|

||||

|

||||

search_tool = DuckDuckGoSearchTool()

|

||||

print(search_tool("Who's the current president of Russia?"))

|

||||

```

|

||||

|

||||

### अपने कस्टम टूल बनाएं

|

||||

|

||||

आप ऐसे उपयोग के मामलों के लिए अपने खुद के टूल बना सकते हैं जो Hugging Face के डिफ़ॉल्ट टूल्स द्वारा कवर नहीं किए गए हैं।

|

||||

उदाहरण के लिए, चलिए एक टूल बनाते हैं जो दिए गए कार्य (task) के लिए हब से सबसे अधिक डाउनलोड किए गए मॉडल को रिटर्न करता है।

|

||||

|

||||

आप नीचे दिए गए कोड से शुरुआत करेंगे।

|

||||

|

||||

```python

|

||||

from huggingface_hub import list_models

|

||||

|

||||

task = "text-classification"

|

||||

|

||||

most_downloaded_model = next(iter(list_models(filter=task, sort="downloads", direction=-1)))

|

||||

print(most_downloaded_model.id)

|

||||

```

|

||||

|

||||

यह कोड आसानी से टूल में बदला जा सकता है, बस इसे एक फ़ंक्शन में रैप करें और `tool` डेकोरेटर जोड़ें:

|

||||

यह टूल बनाने का एकमात्र तरीका नहीं है: आप इसे सीधे [`Tool`] का सबक्लास बनाकर भी परिभाषित कर सकते हैं, जो आपको अधिक लचीलापन प्रदान करता है, जैसे भारी क्लास एट्रिब्यूट्स को इनिशियलाइज़ करने की संभावना।

|

||||

|

||||

चलो देखते हैं कि यह दोनों विकल्पों के लिए कैसे काम करता है:

|

||||

|

||||

<hfoptions id="build-a-tool">

|

||||

<hfoption id="@tool के साथ एक फ़ंक्शन को डेकोरेट करें">

|

||||

|

||||

```py

|

||||

from smolagents import tool

|

||||

|

||||

@tool

|

||||

def model_download_tool(task: str) -> str:

|

||||

"""

|

||||

This is a tool that returns the most downloaded model of a given task on the Hugging Face Hub.

|

||||

It returns the name of the checkpoint.

|

||||

|

||||

Args:

|

||||

task: The task for which to get the download count.

|

||||

"""

|

||||

most_downloaded_model = next(iter(list_models(filter=task, sort="downloads", direction=-1)))

|

||||

return most_downloaded_model.id

|

||||

```

|

||||

|

||||

फ़ंक्शन को चाहिए:

|

||||

- एक स्पष्ट नाम: नाम टूल के कार्य को स्पष्ट रूप से बताने वाला होना चाहिए ताकि इसे चलाने वाले LLM को आसानी हो। चूंकि यह टूल कार्य के लिए सबसे अधिक डाउनलोड किए गए मॉडल को लौटाता है, इसका नाम `model_download_tool` रखा गया है।

|

||||

- इनपुट और आउटपुट पर टाइप हिंट्स।

|

||||

- एक विवरण: इसमें 'Args:' भाग शामिल होना चाहिए, जिसमें प्रत्येक आर्ग्युमेंट का वर्णन (बिना टाइप संकेत के) किया गया हो। यह विवरण एक निर्देश मैनुअल की तरह होता है जो LLM को टूल चलाने में मदद करता है। इसे अनदेखा न करें।

|

||||

इन सभी तत्वों को एजेंट की सिस्टम प्रॉम्प्ट में स्वचालित रूप से शामिल किया जाएगा: इसलिए इन्हें यथासंभव स्पष्ट बनाने का प्रयास करें!

|

||||

|

||||

> [!TIP]

|

||||

> यह परिभाषा प्रारूप `apply_chat_template` में उपयोग की गई टूल स्कीमा जैसा ही है, केवल अतिरिक्त `tool` डेकोरेटर जोड़ा गया है: हमारे टूल उपयोग API के बारे में अधिक पढ़ें [यहाँ](https://huggingface.co/blog/unified-tool-use#passing-tools-to-a-chat-template)।

|

||||

</hfoption>

|

||||

<hfoption id="सबक्लास टूल">

|

||||

|

||||

```py

|

||||

from smolagents import Tool

|

||||

|

||||

class ModelDownloadTool(Tool):

|

||||

name = "model_download_tool"

|

||||

description = "This is a tool that returns the most downloaded model of a given task on the Hugging Face Hub. It returns the name of the checkpoint."

|

||||

inputs = {"task": {"type": "string", "description": "The task for which to get the download count."}}

|

||||

output_type = "string"

|

||||

|

||||

def forward(self, task: str) -> str:

|

||||

most_downloaded_model = next(iter(list_models(filter=task, sort="downloads", direction=-1)))

|

||||

return most_downloaded_model.id

|

||||

```

|

||||

|

||||

सबक्लास को निम्नलिखित एट्रिब्यूट्स की आवश्यकता होती है:

|

||||

- एक स्पष्ट `name`: नाम टूल के कार्य को स्पष्ट रूप से बताने वाला होना चाहिए।

|

||||

- एक `description`: यह भी LLM के लिए निर्देश मैनुअल की तरह काम करता है।

|

||||

- इनपुट प्रकार और उनके विवरण।

|

||||

- आउटपुट प्रकार।

|

||||

इन सभी एट्रिब्यूट्स को एजेंट की सिस्टम प्रॉम्प्ट में स्वचालित रूप से शामिल किया जाएगा, इन्हें स्पष्ट और विस्तृत बनाएं।

|

||||

</hfoption>

|

||||

</hfoptions>

|

||||

|

||||

|

||||

आप सीधे अपने एजेंट को इनिशियलाइज़ कर सकते हैं:

|

||||

```py

|

||||

from smolagents import CodeAgent, HfApiModel

|

||||

agent = CodeAgent(tools=[model_download_tool], model=HfApiModel())

|

||||

agent.run(

|

||||

"Can you give me the name of the model that has the most downloads in the 'text-to-video' task on the Hugging Face Hub?"

|

||||

)

|

||||

```

|

||||

|

||||

लॉग्स इस प्रकार होंगे:

|

||||

```text

|

||||

╭──────────────────────────────────────── New run ─────────────────────────────────────────╮

|

||||

│ │

|

||||

│ Can you give me the name of the model that has the most downloads in the 'text-to-video' │

|

||||

│ task on the Hugging Face Hub? │

|

||||

│ │

|

||||

╰─ HfApiModel - Qwen/Qwen2.5-Coder-32B-Instruct ───────────────────────────────────────────╯

|

||||

━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━ Step 0 ━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━

|

||||

╭─ Executing this code: ───────────────────────────────────────────────────────────────────╮

|

||||

│ 1 model_name = model_download_tool(task="text-to-video") │

|

||||

│ 2 print(model_name) │

|

||||

╰──────────────────────────────────────────────────────────────────────────────────────────╯

|

||||

Execution logs:

|

||||

ByteDance/AnimateDiff-Lightning

|

||||

|

||||

Out: None

|

||||

[Step 0: Duration 0.27 seconds| Input tokens: 2,069 | Output tokens: 60]

|

||||

━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━ Step 1 ━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━

|

||||

╭─ Executing this code: ───────────────────────────────────────────────────────────────────╮

|

||||

│ 1 final_answer("ByteDance/AnimateDiff-Lightning") │

|

||||

╰──────────────────────────────────────────────────────────────────────────────────────────╯

|

||||

Out - Final answer: ByteDance/AnimateDiff-Lightning

|

||||

[Step 1: Duration 0.10 seconds| Input tokens: 4,288 | Output tokens: 148]

|

||||

Out[20]: 'ByteDance/AnimateDiff-Lightning'

|

||||

```

|

||||

|

||||

[!TIP]

|

||||

> टूल्स के बारे में अधिक पढ़ें [dedicated tutorial](./tutorials/tools#टूल-क्या-है-और-इसे-कैसे-बनाएं) में।

|

||||

|

||||

## मल्टी-एजेंट्स

|

||||

|

||||

Microsoft के फ्रेमवर्क [Autogen](https://huggingface.co/papers/2308.08155) के साथ मल्टी-एजेंट सिस्टम्स की शुरुआत हुई।

|

||||

|

||||

इस प्रकार के फ्रेमवर्क में, आपके कार्य को हल करने के लिए कई एजेंट्स एक साथ काम करते हैं, न कि केवल एक।

|

||||

यह अधिकांश बेंचमार्क्स पर बेहतर प्रदर्शन देता है। इसका कारण यह है कि कई कार्यों के लिए, एक सर्व-समावेशी प्रणाली के बजाय, आप उप-कार्यों पर विशेषज्ञता रखने वाली इकाइयों को पसंद करेंगे। इस तरह, अलग-अलग टूल सेट्स और मेमोरी वाले एजेंट्स के पास विशेषकरण की अधिक कुशलता होती है। उदाहरण के लिए, कोड उत्पन्न करने वाले एजेंट की मेमोरी को वेब सर्च एजेंट द्वारा देखे गए वेबपेजों की सभी सामग्री से क्यों भरें? इन्हें अलग रखना बेहतर है।

|

||||

|

||||

आप `smolagents` का उपयोग करके आसानी से श्रेणीबद्ध मल्टी-एजेंट सिस्टम्स बना सकते हैं।

|

||||

|

||||

ऐसा करने के लिए, एजेंट को [`ManagedAgent`] ऑब्जेक्ट में समाहित करें। यह ऑब्जेक्ट `agent`, `name`, और एक `description` जैसे तर्कों की आवश्यकता होती है, जो फिर मैनेजर एजेंट की सिस्टम प्रॉम्प्ट में एम्बेड किया जाता है

|

||||

|

||||

यहां एक एजेंट बनाने का उदाहरण दिया गया है जो हमारे [`DuckDuckGoSearchTool`] का उपयोग करके एक विशिष्ट वेब खोज एजेंट को प्रबंधित करता है।

|

||||

|

||||

```py

|

||||

from smolagents import CodeAgent, HfApiModel, DuckDuckGoSearchTool, ManagedAgent

|

||||

|

||||

model = HfApiModel()

|

||||

|

||||

web_agent = CodeAgent(tools=[DuckDuckGoSearchTool()], model=model)

|

||||

|

||||

managed_web_agent = ManagedAgent(

|

||||

agent=web_agent,

|

||||

name="web_search",

|

||||

description="Runs web searches for you. Give it your query as an argument."

|

||||

)

|

||||

|

||||

manager_agent = CodeAgent(

|

||||

tools=[], model=model, managed_agents=[managed_web_agent]

|

||||

)

|

||||

|

||||

manager_agent.run("Who is the CEO of Hugging Face?")

|

||||

```

|

||||

|

||||

> [!TIP]

|

||||

> कुशल मल्टी-एजेंट इंप्लीमेंटेशन का एक विस्तृत उदाहरण देखने के लिए, [कैसे हमने अपने मल्टी-एजेंट सिस्टम को GAIA लीडरबोर्ड के शीर्ष पर पहुंचाया](https://huggingface.co/blog/beating-gaia) पर जाएं।

|

||||

|

||||

|

||||

## अपने एजेंट से बात करें और उसके विचारों को एक शानदार Gradio इंटरफेस में विज़ुअलाइज़ करें

|

||||

|

||||

आप `GradioUI` का उपयोग करके अपने एजेंट को इंटरैक्टिव तरीके से कार्य सौंप सकते हैं और उसके सोचने और निष्पादन की प्रक्रिया को देख सकते हैं। नीचे एक उदाहरण दिया गया है:

|

||||

|

||||

```py

|

||||

from smolagents import (

|

||||

load_tool,

|

||||

CodeAgent,

|

||||

HfApiModel,

|

||||

GradioUI

|

||||

)

|

||||

|

||||

# Import tool from Hub

|

||||

image_generation_tool = load_tool("m-ric/text-to-image", trust_remote_code=True)

|

||||

|

||||

model = HfApiModel(model_id)

|

||||

|

||||

# Initialize the agent with the image generation tool

|

||||

agent = CodeAgent(tools=[image_generation_tool], model=model)

|

||||

|

||||

GradioUI(agent).launch()

|

||||

```

|

||||

|

||||